微软继续受益于OpenAI的合作

有外国分析师认为,OpenAI“o”系列通过引入扩展推理,这一举措将大大推进技术发展。而这将有利于微软长期受益于AI浪潮。

作者:Simple Investment Ideas

从单次传递到扩展推理

传统的生成型AI模型,如GPT-4,通过单次前向传递生成响应;它们接收一个提示,处理它,并在不重新访问或修改初始推理的情况下产生一个答案。虽然这种“单次传递”方法对于简单的查询很有效,但在处理需要更深层次的逻辑思考时,面对复杂、多步骤问题,它往往远远不够。

OpenAI的“o”系列通过引入扩展推理来革命性地改变这一范式,这是一种模型在最终确定答案之前进行多次迭代推理步骤的方法。这是通过CoT(链式推理)实现的,模型内部将问题分解为更小、更易管理的子步骤。如果模型在其初始推理中检测到不一致和错误,它可以回溯并修正其逻辑,直到找到一个连贯且准确的解决方案。事实上,我们要求这些模型进行扩展推理的时间越长,答案通常就越准确。

这种方式类比于人类的话,著名科学家爱因斯坦就是一个很好的例子。发展相对论并不是爱因斯坦的一次“前向传递”,他不会在想到的前1000个词中就提出理论。相反,爱因斯坦可能花了几年时间思考和修正他的想法,然后才提出了革命性的相对论。这种漫长而深思熟虑的思考方式更类似于“o”系列模型使用“扩展推理”的工作方式。

“扩展推理”最吸引人的方面是,OpenAI的研究人员仍然没有找到这些推理模型在达到平台期之前从事“扩展推理”的时间限制。这在直觉上是有意义的,因为它类似于人类在“思考”很长时间后通常会提出更好的答案,或者在模型的情况下,执行“扩展推理”。在实践中,让模型执行一秒钟的扩展推理比让模型思考一分钟的结果更差。同样地,让模型思考一分钟会比让模型思考一小时产生更糟糕的结果。这种“扩展推理”实际上可以被视为文本输出,所以一个“思考”一个小时的模型可以从字面上喷出长篇小说的“思考数据”,类似于一个人在纸上草草写下想法,直到他们确信自己是正确的。这个事实在后面会很重要。

因此,OpenAI已经破解了如何“扩展推理”的代码,即找到一种方法,使模型花在“推理”或“思考”上的时间越多,答案就越准确。这与传统的LLM模型不同,在传统的LLM模型中,它给出准确答案的能力与你要求模型“思考”多长时间并没有太大的关联。OpenAI现在用“o”系列模型进行“规模化推理”的能力是真正的突破。OpenAI的研究科学家Noam Brown领导了这项工作,他认为这还需要10年的时间,因为缩放推理的问题已经解决了。相反,OpenAI只花了几年时间,现在我们有了革命性的“o3”模型。这具有巨大的意义,因为它现在为基础模型公司提供了两个向量,一个是传统的预训练,另一个是测试时间计算,即在模型已经预训练的推理时间。

这是一个“o”模型在给出“公主的年龄是...”这个问题的答案之前开始“思考”的例子。如你所见,模型开始分解问题,使其对自身更清晰。

强化学习以迭代改进

为了掌握“扩展推理”,或简单地说“思考”,OpenAI增加了一个额外的强化学习层来训练其“o”系列推理模型。在广泛的文本预训练之后,这些模型经历了一个额外的强化学习阶段,在那里它们被训练以优化它们的思维过程。在这个阶段,模型为给定的提示生成多个潜在的推理路径。奖励机制,无论是基于AI的评估器还是人类反馈,都根据其正确性对每条路径进行评分。正面的奖励通过调整模型权重来加强有效的推理模式,以便在未来更有可能产生这样的推理路径。

作为一个非常简单的例子,假设给一个模型出了一个非常困难的数学问题,解决方案是1049。假设模型被提示了1000次这个确切的数学问题。结果,模型随后创建了1000个推理链,每个推理链对应于它被提示的确切相同的数学问题。然后假设这1000个推理链中只有10个得出了正确的答案1049。然后模型将调整其权重,以便在未来更有可能产生这10个“正确”的推理链。

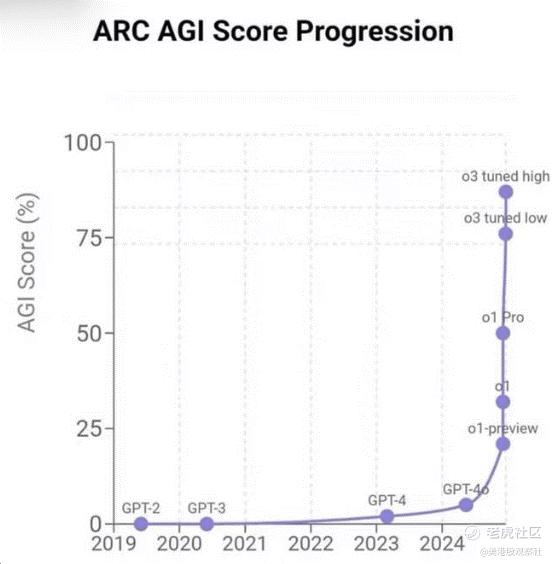

现在,将数百万计的这类问题投向模型,从数学题到编程题,其中答案是客观的,并允许这些模型通过持续的权重/参数调整不断提炼其内部推理逻辑,很容易看出这样的模型将能够随着时间的推移提高其一般推理能力,以至于模型能够解决甚至超出其数据集的问题。这基本上通过其在ARC-AGI-PUB测试中的出色成绩得到了证明,该测试测试模型回答其数据集之外的问题的能力,被视为测试模型“一般智能”的圣杯。

进一步使用合成数据:超越“垃圾进垃圾出”

这些推理模型的一个好处是,“正确”推理路径现在可以作为合成训练数据反馈给模型。这些推理路径是高质量的、自我策划的训练示例,它们增强了模型的性能,而不仅仅依赖于人类标记的数据。由正确推理路径创建的合成数据之所以如此高质量,是因为这样的推理更有可能是正确的。毕竟,它们是产生正确答案的推理路径!

早期的合成数据方法常常与“垃圾进垃圾出”的问题作斗争,合成生成的数据要么微不足道,要么无关紧要,导致模型性能不佳甚至模型崩溃,就像蛇吃自己的尾巴一样。相比之下,“o”系列使用验证步骤来保持其合成数据的质量高。用更简洁的术语重申,当模型在训练中解决一个具有挑战性的问题时,它生成多个推理路径,并识别那些成功导致正确解决方案的路径。

这些经过验证的推理路径随后被存储为新的训练示例,有效地创建了一个高保真数据库,捕捉了解决问题技术的细微差别。与随机或简单的数据不同,这种自生成的合成数据既高度相关又有价值,显著增强了模型在不同领域泛化的能力。这就是所谓的“微调”,与强化学习相结合,很可能导致了“o”推理模型的突破。

想象在预训练过程中,下图中的每一条线都是一个推理链。错误答案的链被修剪,好的推理链可以反馈回模型进行微调。

对微软的影响

这意味着什么?自从“o”推理范式诞生以来,进展的速度令人震惊,没有明确的迹象表明其扩展有限制。此外,ARC基准分数呈指数增长,表明真正的推理智能可能以指数速度增长。我们可能正在见证一个不可阻挡的飞轮效应,OpenAI现在能够比竞争对手生成更多的合成数据,从而以更快的速度改进其模型,这反过来可以以更快的速度生成更有用的数据。

这一切因OpenAI的模型迄今为止使用最广泛而变得更加复杂,每周拥有约3亿用户,这意味着OpenAI将能够通过巧妙地使用客户查询产生的推理,以比竞争对手高得多的速率进一步微调其未来模型。这是一种来自OpenAI庞大客户基础的额外网络效应。当然,正如下面将讨论的,所有这些都将对微软产生非常积极的影响。

现在广为讨论的“AI墙”现在看起来更像是未来学家所流行的“AI起飞”概念,进步的线条增长如此之快,以至于看起来像一堵“墙”。这与许多AI怀疑论者预测的情况完全相反。

Azure的AI驱动扩张

OpenAI模型智能的加速起飞对微软有着巨大的影响,微软基本上可以首先使用OpenAI的模型,这是由于它与该公司的合作关系。微软与OpenAI的战略合作关系使其处于这个飞轮的核心。通过将这些模型整合到其Azure平台中,微软可以为企业提供最先进的云AI模型和工具,极大地提高生产力。

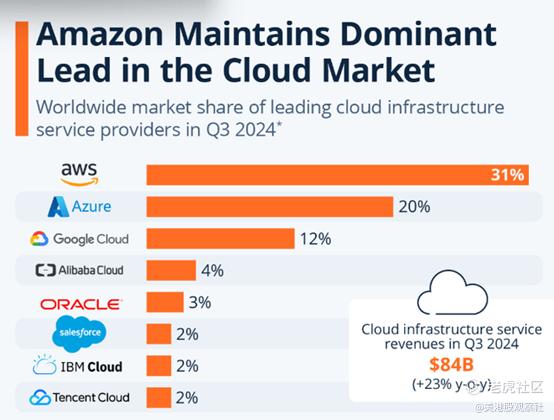

Azure的智能云部门在2025财年第一季度单独增长了20%,达到241亿美元。AI服务单独贡献了Azure增长的约12个百分点。然而,Azure不仅仅是OpenAI技术的被动受益者。鉴于企业之间的竞争如此激烈,能够访问最新模型可能具有巨大的优势,这将使微软在吸引客户使用其云服务方面拥有巨大的优势。事实上,能够访问最尖端模型可能是企业客户的差异化因素,特别是鉴于与亚马逊或谷歌的竞争如此接近。

云霸权之战正变得越来越紧张,使任何区分自己与竞争对手的手段成为Azure成功的关键。

Microsoft 365和企业AI集成

微软还能够将“o”系列能力整合到其无数的软件产品中,如Microsoft 365 Copilot和GitHub Copilot。微软产品性能的提升几乎肯定会吸引更多用户,并培养更大的客户忠诚度。此外,如果客户看到真正的生产力提升,企业级采用这些AI工具可能特别粘性。

如果企业能够通过使用OpenAI最先进的模型节省员工每周几个小时的生产力,它们很可能愿意支付高昂的溢价。无论溢价有多昂贵,人类几乎总是比运行推理更昂贵,即使是最大和最复杂的模型。毫不奇怪,微软认识到这一潜力,并正在向其AI基础设施投入巨额资金。

仅在2025财年第一季度,微软就在AI和云基础设施上投资了2000亿美元,并预计在2025财年将花费超过8000亿美元。这种积极的投资确保了微软能够充分利用高性能计算的增长需求和扩展推理所需的资源。虽然这些投资将对利润率产生短期压力,但它将使微软在AI领域长期增长和领导地位。

仍然存在巨大风险

微软仍面临来自其他超大规模企业的若干重大风险。激烈的竞争是主要关注点,因为其他主要科技巨头如亚马逊和谷歌也在投资数十亿美元与竞争的基础模型制造商竞争。鉴于由Anthropic或谷歌创建的模型通常最多落后于OpenAI几个季度,OpenAI的任何小失误都将给竞争模型制造商足够的时间迎头赶上。事实上,许多行业专家已经推测,这种情况一直持续到OpenAI宣布其开创性的“o3”模型。

微软面临的另一个主要风险是OpenAI实际上实现了AGI,在这一点上,他们协议中的一个条款规定微软将无法再访问其模型。然而,即使是OpenAI也希望移除这一条款以吸引微软的更多投资。此外,所谓的AGI是非常主观的。如果OpenAI和微软都希望继续他们的交易,他们几乎肯定会找到绕过这一条款或完全移除它的方法。

总结

如果这些“o”推理模型确实是AI起飞到真正的AGI的开始,微软的股价可能会因为首先访问这些模型而爆炸。一旦竞争基础模型制造商赶上OpenAI的当前迭代,OpenAI可能会再次领先,这最终意味着微软领先。即使在其市值达到3.3万亿美元的情况下,该公司的前瞻性市盈率为33,如果OpenAI的“o”推理模型像看起来那样革命性,那么仍有更大的上升空间。

$微软(MSFT)$

交易商排行

更多- 监管中EXNESS10-15年 | 英国监管 | 塞浦路斯监管 | 南非监管92.42

- 监管中FXTM 富拓10-15年 |塞浦路斯监管 | 英国监管 | 毛里求斯监管88.26

- 监管中axi15-20年 | 澳大利亚监管 | 英国监管 | 新西兰监管79.20

- 监管中GoldenGroup高地集团澳大利亚| 5-10年85.87

- 监管中Moneta Markets亿汇澳大利亚| 2-5年| 零售外汇牌照82.07

- 监管中GTCFX10-15年 | 阿联酋监管 | 毛里求斯监管 | 瓦努阿图监管60.90

- 监管中VSTAR塞浦路斯监管| 直通牌照(STP)80.00

- 监管中IC Markets10-15年 | 澳大利亚监管 | 塞浦路斯监管91.81

- 监管中金点国际集团 GD International Group澳大利亚| 1-2年86.64

- 监管中CPT Markets Limited5-10年 | 英国监管 | 伯利兹监管91.56