马斯克为什么一定要开源AI?

千呼万唤始出来。

为了兑现牛逼,马斯克最近下了血本:Grok-1宣布开源。

据官方信息,这是一个参数高达3140亿的混合专家模型,是目前所有开源模型中规模最大的。

甚至,Grok-1还采用Apache 2.0许可证,这意味着它对商业使用是友好的。

老马直言,他就是要证明他的开放性和透明度,就是要嘲讽ClosedAI。

大家可能都觉得有些腻了,马斯克最近整活的频率也太高了。

对开源这回事,为什么就必须要死咬着不放?

01

AI比核弹更危险

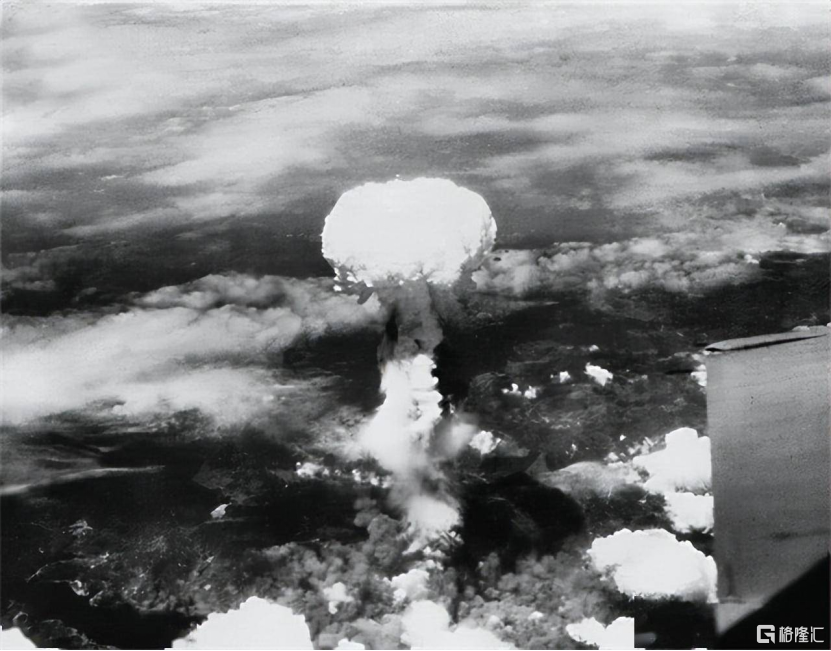

1914年,韦尔斯在《世界被解放》中对核武器做出美好幻想:

“原子弹在他们笨拙的手中爆炸之前……在最后一场战役开始前,人们都知道,一个人可以用手提包携带足以摧毁半个城市的破坏能量。”

他认为,核弹的威力是如此之大,以至于人们一定会想方设法创建一个乌托邦政府,以防止武器被滥用。

这跟动漫《火影忍者》里佩恩的理念非常类似,制作能瞬间消灭一个城市的超级武器,让所有人都生活在恐惧中,世界自然就和(核)平了。

后来的历史告诉我们,这种想法是有些天真的,没有人愿意被别人统治。

但也不是完全没有道理。

当时有不少人开始担心,当第一个国家拥有原子弹时,会发生什么?它将在战争中势不可挡,并一定会用铁腕手段统治世界。

1945年,两颗原子弹前所未有的杀伤力,瞬间击溃日本“一亿玉碎”的计划,席卷世界的大战很快就结束。

但此时,和平并不算到来。美国是唯一的有核国家,谁知道下一个核打击对象是不是自己?生死取决于某一方的态度,不受制约,就谈不上和平。

直到这种力量,不再是被某一家垄断。

冷战期间,美苏双方已经到了你死我生的局面,之所有没有爆发大规模战争,就是因为威慑性武器不再是谁的独有。

这种虚假的和平,一直持续到今天。如果不是各方互相制衡,大家是很难做到谈判桌前平静交谈的。

虚假的和平,也是和平,总比无限的战争好一万倍。

AI的性质,与核弹有些类似。

之前我们计算过AGI所需要的资源量,先不论是否正确,有一点是确定的:AGI一定能实现,只不过时间长短未知。

既然如此,我们在担心自己的工作被抢走之前,其实应该先思考一个问题:谁控制着AI。

现在,我们仿佛又回到原子弹出现前的那个时代。

当第一家企业拥有AGI时,会发生什么?

如果只把AGI当作商业武器,毫无疑问,它将横扫还没有AGI的所有对手,垄断全行业,实现一波财富大爆发。

直到,它失去垄断地位,市场才重新恢复竞争局面。

就像过去半个多世纪,核弹对这个世界造成的局面一样。

但这只是最好的情况。

马斯克不止一次说:“在我看来,人工智能比核弹更危险。”

在我看来,他所指的危险,并不只是说破坏力,而是存在方式。

核弹威力再大,终究是死物。如果没有人为去引爆,它就是个铁疙瘩。

但AGI,谁都无法预料它是否会诞生基本的生物本能。

如果它是“活”的,即便不会伤害自己的造物主,也绝对会想方设法消灭可能威胁到自己的“同类”。

不论是人还是其他任何动物,都会为了食物、土地等资源,残酷杀死竞争对手。

这是生物界的共性,是无法避免的本能。

对人工智能而言,最宝贵的资源就是算力和能源,这相当于它的食物。AGI想要更进一步进化成超级AI,所需要消耗的资源呈指数增长。

所以,哪怕它只领先一分钟实现AGI,都很可能杀死其他还在襁褓中的同类们,防止它们将来抢食。

一旦这种事情发生,最先出头的那家企业会一直垄断下去,这不论对行业还是整个社会,都是不好的。

我们需要充分的竞争,不能让某一家企业遥遥领先下去。

02

拒绝赛博朋克

在游戏《赛博朋克2077》中,超级科技巨头荒坂集团掌控着大部分国家的政府及经济命脉,渗透进所有人生活的每个角落。

它就像扎根在夜之城的参天巨树,敲骨吸髓地汲取普通人为数不多的养分。

这个时代,“上等人”享尽科技霸权的红利,在摩天大楼和飞行汽车里纸醉金迷,双脚几乎不沾地;普通人则只能世世代代在充满辐射、垃圾和杀戮的拥挤街道,挣扎求生。

朱门酒肉臭,路有冻死骨。

科技飞跃发展,底层人却苦不聊生,这就是技术垄断必然造成的病态社会缩影。

这不仅仅只是警示。

假如AGI长期垄断在某一家手中,这可能就是未来的剧本。

在古代,武器=权利;在近现代,金钱=权利;在未来,科技=权利。

你根本无法预料某些人掌握绝对权利后会做什么。

即便他是所谓的“仁君”,那下一任呢?

无论什么时候,权利都需要制约。

我有同归于尽、掀桌子的力量,凭什么被你统治?

开源AI,客观来说,就是这种效果。

就目前而言,OpenAI在大模型这条赛道上的先发优势,是毋庸置疑的。

这是个堆数据、堆资源、堆时间的活,如果搞闭源,谁都不可能追上GPT。

别说什么超越GPT-3.5多少、只比GPT-4差多少,只要差一点,等到OpenAI实现AGI的那一刻,所有后发者的命运都是一样的。

既然单靠自己不行,就只能借助外力。

既然先发优势不可更改,那就学曾经安卓那一套,搞开源系统就是了。

开源意味着模型的源代码、所有用于训练模型权重和参数都是可公开访问、可用、可修改的,并且允许转载。

简单来说,就是邀请全世界开发者给自己打工,以此来挑战已有的闭源生态。

这样做,至少有六点好处:

1.降低进入门槛。让更多人参与,为AI发展提供动力。

2.加速研究进展。开发者可以在开源代码和数据的基础上,直接研究和创新。

3.促进产业应用普及。开源的算法和模型,可以被更多企业应用和商业化,推动AI应用落地。

4.帮助确保公平和透明。公开开源代码可以让社会对算法过程进行审查,确保其公平性和透明度。

5.节省计算和人力成本。可以在已有开源成果上继续创新,而非重复基础工作,节约大量计算和人力成本。

6.增强可重复性和可扩展性。其他人可以复现开源项目的实验,并在此基础上进行扩展,推动科技深入发展。

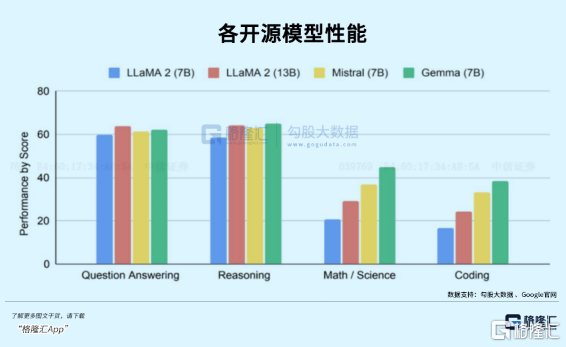

以Meta的开源大模型Llama2为例,短短几个月,通过Hugging Face下载的基于Llama的模型超过3000万次,开源AI社区上发布了超过7000个Llama衍生模型。

Meta在技术和资金上确实拼不过微软和OpenAI。

但就像当年的安卓一样,群众的力量是恐怖的。

不论是Meta的Llama,还是谷歌的Gemma,都能用开源的方式,像曾经的安卓那样在智能手机时代分一杯羹。

包括马斯克自己,乃至未来更多的开源大模型,都是这种玩法。

这是商业的角度。

再从伦理角度看,早在2015年,马斯克与山姆·奥特曼就讨论了这个问题:由大公司控制的少量AI系统更安全,还是大量独立系统更安全?

当时两人一致更认同后者。

逻辑就是,只要有大量彼此竞争的AI相互制衡,就算少部分AI“变质”了,产生自由意识脱离掌控,其他大量的独立系统也会联合剿灭它。

这就是马斯克心中AI最安全的发展路径:防止人类滥用AI的最佳防火墙,就是让尽可能多的人都拥有AI。

简单来说,就是提高容错率。

总之,开源不仅能促进技术更快发展,还能有效避免技术被某一家巨头垄断,更能让发展AI这条路线更加安全。

但它并不是完全没有坏处。

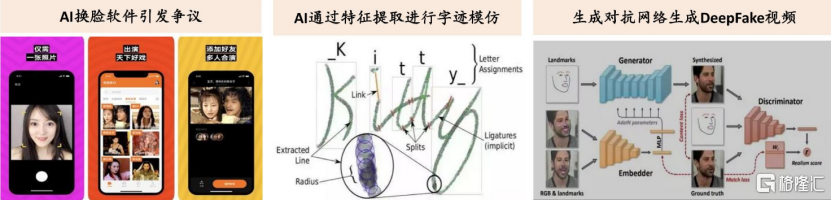

至少对外,关于为什么要闭源,OpenAI是这么解释的:防止AI被滥用。

就像枪支一样,如果按照马斯克的理念,人人手里都有枪,犯罪事件是不是就更多了?

要是把枪支,换成比核弹更危险的原子弹,是不是更危险?

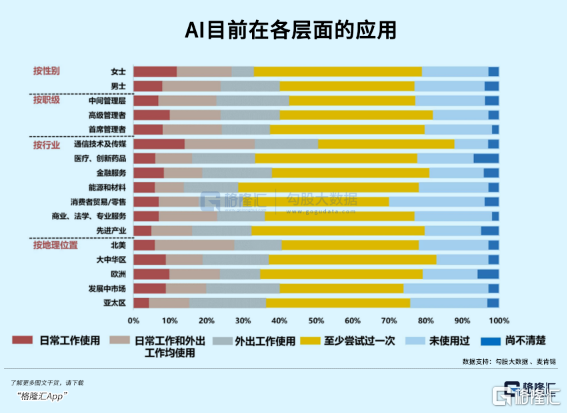

目前AI技术滥用的几种形式

这种担心不无道理,可能性不是没有。但既然后来者们越来越多选择开源,等到GPT的先发优势越来越小的时候,它会怎么选择呢?

如果OpenAI妥协,也被迫选择开源,届时AI技术爆发的时代才真正带来。

只是福祸难以预料。

03

尾声

当然,上面说了这么多,马斯克也不是纯粹要做慈善。

他毕竟是个商人,赚钱才是最主要的目的。

比如,2014年他为什么要开源300项特斯拉专利?

因为汽车百多年的历史中,内燃机是主流,牵扯到的利益不仅仅是老牌工业巨头,更是那些富可敌国的油商和海湾国家。

凭他一个人,想撼动这棵盘根错节的巨树,单挑德国、日本的发动机巨头和阿拉伯土豪,是不可能的。

所以得拉人、拉很多人。

怎么才能快速获得盟友?最简单粗暴的就是释放利益,把技术分享出去,降低入行门槛。

当然,并不是无偿分享,有两个很重要的前提:

1.只有心怀善意的企业,可以免费使用专利。如何定义善意?特斯拉说了算。

2.一旦使用这些技术,也就默认特斯拉可以免费使用你的任何专利。

这次开源大模型Grok-1,或许也有类似的条件。。

橘生淮南则为橘,生于淮北则为枳。

人工智能的爆发,在太平洋东西两岸“叶徒相似,其实味不同”。

那边对开源闭源吵得热火朝天,这边却有人虚空买课上热搜,更有大佬公开直言:我信仰个毛线,我只信钱,这就是中国现实主义AIGC。

现在AI方面的差距,大家都懂,国内资本界天天盼着他们开源呢!这样才能抄作业。

但这其实是味慢性毒药。

就像新能源车,短期看成绩喜人,长期看很可怕。

从0到1不是那么简单的事情,我们习惯了拿来主义,习惯了吃“快餐”,根本坐不住,沉不住气,甚至失去了思考能力。(全文完)

交易商排行

更多- 监管中EXNESS10-15年 | 英国监管 | 塞浦路斯监管 | 南非监管88.77

- 监管中FXTM 富拓10-15年 |塞浦路斯监管 | 英国监管 | 毛里求斯监管85.36

- 监管中GoldenGroup高地集团澳大利亚| 5-10年85.87

- 监管中金点国际集团 GD International Group澳大利亚| 1-2年86.64

- 监管中Moneta Markets亿汇澳大利亚| 2-5年| 零售外汇牌照80.52

- 监管中IC Markets10-15年 | 澳大利亚监管 | 塞浦路斯监管91.71

- 监管中CPT Markets Limited5-10年 | 英国监管 | 伯利兹监管91.56

- 监管中GO Markets高汇15-20年 | 澳大利亚监管 | 塞浦路斯监管 | 塞舌尔监管87.90

- 监管中alpari艾福瑞5-10年 | 白俄罗斯监管 | 零售外汇牌照87.05

- 监管中AUS Global5-10年 | 塞浦路斯监管 | 澳大利亚监管86.47