最新消息:英伟达市值突破万亿 Computex新闻要点汇总

Computex新闻要点汇总

黄仁勋在台北举行的Computex上表示,他希望将生成式人工智能引入每个数据中心。在这次演讲中,黄仁勋进行了近四年来的首次公开演讲,并宣布了一系列新闻,包括芯片发布日期、其DGX GH200超级计算机以及与主要公司的合作伙伴关系。以下是这次长达两个小时的主题演讲的所有新闻:

1. Nvidia的面向游戏玩家的GForce RTX 4080 Ti GPU现已全面投产,并与台湾的合作伙伴一起大规模生产。

2. 黄仁勋宣布了适用于游戏的Nvidia Avatar Cloud Engine(ACE),这是一个可定制的AI模型铸造服务,为游戏开发者提供预训练模型。它将通过基于AI的语言交互为NPC赋予更多个性。

3. Nvidia的Cuda计算模型现已为400万开发人员和3000多个应用程序提供服务。Cuda已经实现了4000万次下载,其中单单去年就有2500万次下载。

4. GPU服务器HGX H100的大规模生产已经开始,并由“遍布台湾的各个公司”进行制造,黄仁勋表示。他补充说,这是世界上第一台具有变压器引擎的计算机。

5. 黄仁勋提到了Nvidia于2019年以69亿美元收购超级计算机芯片制造商Mellanox的交易,称它为“Nvidia有史以来最伟大的战略决策之一”。

6. 下一代Hopper GPU的生产将于2024年8月开始,恰好是第一代开始生产的两年后。

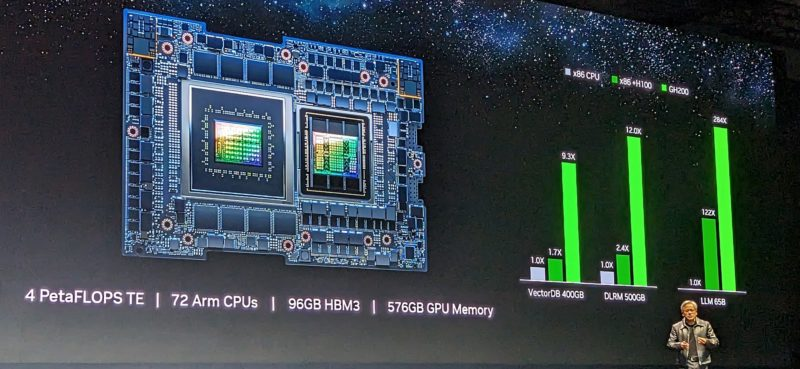

7. Nvidia的GH200 Grace Hopper现已全面投产。这款超级芯片拥有4 PetaFIOPS TE的性能,由72个Arm CPU通过芯片间连接进行连接,搭配96GB的HBM3和576GB的GPU内存。黄仁勋将其描述为世界上第一款既具备巨大内存又具备加速计算功能的处理器:“这是一台计算机,而不仅仅是一颗芯片。”它专为高弹性的数据中心应用而设计。

8. 如果Grace Hopper的内存不足,Nvidia有解决方案——DGX GH200。首先,将8颗Grace Hopper芯片通过3个NVLINK交换机连接起来,然后在900GB的连接中将这些节点连接在一起。最后,再连接32个这样的节点,并通过另一层交换机连接起来,以连接总共256颗Grace Hopper芯片。所得到的ExaFLOPS变压器引擎具备144TB的GPU内存,并可作为巨大的GPU使用。黄仁勋表示,Grace Hopper的速度非常快,可以在软件中运行5G协议栈。谷歌云、Meta和微软将成为首批获得DGX GH200访问权限的公司,并将对其性能进行研究。

9. Nvidia与SoftBank达成合作伙伴关系,将在日本SoftBank的新分布式数据中心引入Grace Hopper超级芯片。它们将能够在多租户共享服务器平台上托管生成式人工智能和无线应用,降低成本和能源消耗。

10. SoftBank-Nvidia合作将基于Nvidia MGX参考架构,该架构目前已与台湾的公司合作使用。它为系统制造商提供了一个模块化的参考架构,帮助他们构建100多种用于人工智能、加速计算和全宇宙(omniverse)应用的服务器变种。合作伙伴公司包括华擎(ASRock Rack)、华硕(Asus)、技嘉(Gigabyte)、和硕(Pegatron)、世硕(QCT)和超微(Supermicro)。

11. 黄仁勋宣布了Spectrum-X加速网络平台,旨在提高基于以太网的云计算速度。该平台包括Spectrum 4交换机,拥有每秒400GB的128个端口和每秒51.2T的吞吐量。黄仁勋表示,这款交换机旨在实现一种新型以太网,并端到端地设计用于自适应路由、隔离性能和内部计算。它还包括Bluefield 3智能网卡,用于连接Spectrum 4交换机以进行拥塞控制。

12. 世界上最大的广告公司WPP已与Nvidia合作开发基于Nvidia Omniverse的内容引擎。该引擎能够生成用于广告的照片和视频内容。

13. 任何想要构建机器人的人现在都可以使用Nvidia Isaac ARM机器人平台,它是从芯片到传感器的全套解决方案。黄仁勋表示,Isaac ARM从一款名为Nova Orin的芯片开始,是第一个完整的机器人参考堆栈。

由于其在人工智能计算中的重要性,Nvidia的股价在过去一年中飙升,目前市值约为万亿美元,使其成为世界上最有价值的公司之一(只有苹果、微软、沙特阿美、Alphabet和亚马逊的市值更高)。

中国业务陷入困境

毫无疑问,中国的人工智能公司正密切关注Nvidia所带来的最先进的芯片技术。与此同时,他们可能对即将到来的美国芯片禁令感到担忧,这可能会破坏他们在生成式人工智能方面的进展,而这种技术需要比以往更多的计算能力和数据。

去年,美国政府限制了Nvidia向中国销售A100和H100图形处理单元。这两款芯片用于训练像OpenAI的GPT-4这样的大型语言模型。H100是Nvidia基于Hopper GPU计算架构开发的最新一代芯片,配备了内置的变压器引擎,目前正受到特别高强度的需求。与A100相比,H100能够提供9倍更快的人工智能训练速度和高达30倍更快的LLM人工智能推理速度。

中国市场显然是一个不可错过的机会。芯片出口禁令仅在去年第三季度就给Nvidia造成了大约4亿美元的潜在销售损失。因此,Nvidia只得向中国出售符合美国出口管制规定的较慢芯片。但从长远来看,中国可能会寻求更强大的替代品,并且该禁令提醒中国在关键技术领域实现自力更生的重要性。

正如黄仁勋最近在接受《金融时报》采访时所说:“如果(中国)无法从美国购买,他们就会自己建设。因此,美国必须小心。中国对技术产业来说是一个非常重要的市场。”

原文由Catherine Shu, Rita Liao撰写,中文内容由元宇宙之心(MetaverseHub)团队编译,如需转载请联系我们。

来源:金色财经

交易商排行

更多- 监管中EXNESS10-15年 | 英国监管 | 塞浦路斯监管 | 南非监管93.02

- 监管中FXTM 富拓10-15年 |塞浦路斯监管 | 英国监管 | 毛里求斯监管88.21

- 监管中FXBTG10-15年 | 澳大利亚监管 |83.48

- 监管中GoldenGroup高地集团澳大利亚| 5-10年85.87

- 监管中IC Markets10-15年 | 澳大利亚监管 | 塞浦路斯监管91.71

- 监管中CPT Markets Limited5-10年 | 英国监管 | 伯利兹监管91.56

- 监管中AUS Global5-10年 | 塞浦路斯监管 | 澳大利亚监管86.47

- 监管中OneRoyal10-15年 | 澳大利亚监管 | 塞浦路斯监管 | 瓦努阿图监管85.75

- 监管中易信easyMarkets15-20年 |澳大利亚监管 | 塞浦路斯监管85.38

- 监管中FXCC10-15年 | 塞浦路斯监管 | 直通牌照(STP)85.26